Použiteľnosť a použiteľnosť modelov strojového učenia sa testuje na dátach. Spoľahlivosť testov vo veľkej miere závisí od množstva a kvality údajov, na ktorých sú tieto modely aplikované. Vytvorenie, získanie a čistenie vhodne veľkého súboru údajov na otestovanie vášho „ Spracovanie prirodzeného jazyka (NLP) “Model strojového učenia.

Hugging Face na to ponúka elegantné riešenie s výnimočne veľkou knižnicou súborov údajov, z ktorých si môžete vybrať a nájsť ten, ktorý dokonale vyhovuje vašim požiadavkám. Tu vám ukážeme, ako nájsť ideálny súbor údajov a pripraviť ho na adekvátne testovanie vášho modelu.

Ako používať množiny údajov Hugging Face?

Ukážeme vám, ako používať množiny údajov Hugging Face na príklade „ TinyStories Súbor údajov z Hugging Face.

Príklad

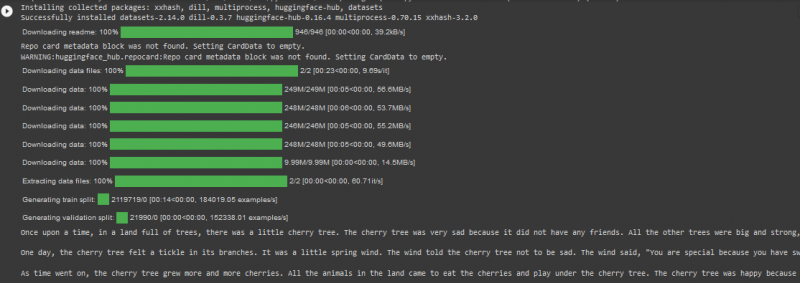

TinyStories Dataset má viac ako 2 milióny riadkov údajov vo vlakovom rozdelení a má viac ako 2 tisíc stiahnutí na platforme Hugging Face. Použijeme ho v kóde v službe Google Colab nižšie:

! pip Inštalácia transformátory

! pip Inštalácia množiny údajov

z dátových množín importovať load_dataset

dataset = load_dataset ( 'roneneldan/TinyStories' )

TinyStories_Story = 3

example_string = množina údajov [ 'vlak' ] [ TinyStories_Story ] [ 'text' ]

vytlačiť ( example_string )

V tomto kóde zvážte nižšie uvedené kroky:

Krok 01 : Prvým krokom je „ inštalácia ” súborov údajov transformátorov.

Krok 02 : Ďalej importujte požadovaný súbor údajov, “ TinyStories “ do vášho projektu.

Krok 03 : Ďalej načítajte vybraný súbor údajov pomocou „ load_dataset() “.

Krok 04 : Teraz zadáme požadované číslo príbehu zo súboru údajov TinyStories. V našom príklade kódu sme zadali číslo 03.

Krok 05 : Nakoniec použijeme metódu „print()“ na zobrazenie výstupu.

Výkon

Poznámka: Kód a výstup je možné zobraziť aj priamo v našej službe Google Colab .

Záver

“ Súbory údajov Hugging Face ” umožňuje používateľom neuveriteľne efektívne testovať svoje modely strojového učenia a zároveň priamo importovať veľké súbory údajov z ich online knižnice. Výsledkom je, že aplikácia algoritmov NLP je jednoduchšia a rýchlejšia, pretože programátori môžu svoje projekty testovať na základe súboru údajov, ktorý má kvalitu aj kvantitu.